谷歌Gemini Pro模型 Api 调用

本文主要介绍如下内容

- Gemini Pro模型 ApiKey的申请

- Gemini Pro模型 Api调用的方法

- 几个模型Api调用的demo程序

- 调用Gemini Pro模型中可能遇到的问题及解决方案

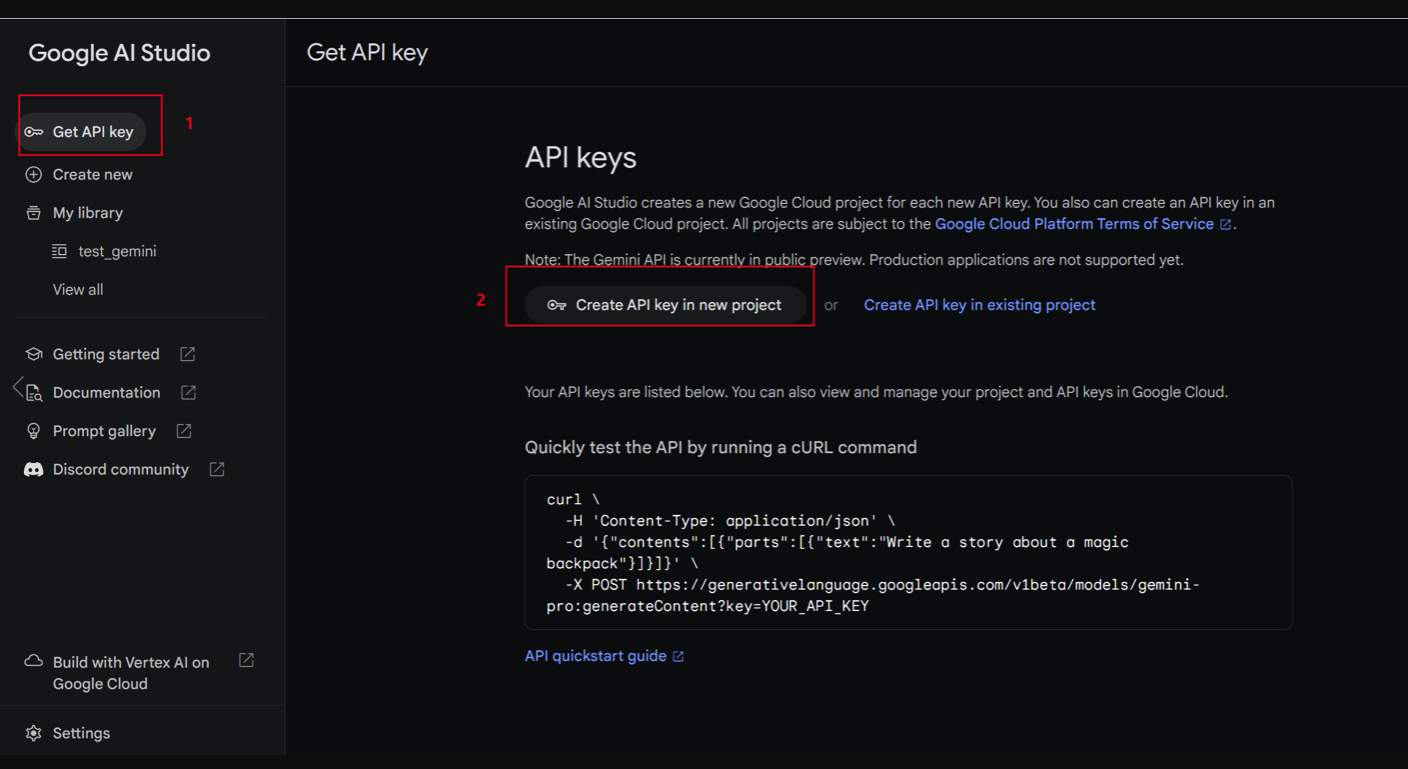

模型 ApiKey的申请

- 注册好Google账号,并在浏览器完成登录

- 访问 : https://makersuite.google.com/app/apikey

- 按照下图操作,获取key

调用方法

一、 使用http进行调用

import requests

import json

def test_with_http(apikey, text):

url = f'https://generativelanguage.googleapis.com/v1beta/models/gemini-pro:generateContent?key={apikey}'

headers = {'Content-Type': 'application/json'}

data = {

'contents': [

{

'parts': [

{

'text': text

}

]

}

]

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.json())

if __name__ == '__main__':

apikey = "这里换成ApiKey"

text = "请做一个自我介绍"

test_with_http(apikey=apikey, text=text)

二、基于Google提供的 Python 库

注意

根据Gemini Api的使用文档介绍,要求Python版本在3.9以上,本次测试为 3.10 版本。

步骤

1.(可选) 建议创建一个全新的Python虚拟环境: python -m venv pyvenv

2.(可选)激活当前环境 : .\pyvenv\Scripts\activate

3. 安装Google提供的google-generativeai库:pip install google-generativeai

4. 测试代码:

import google.generativeai as genai

def test_with_api(apikey, text):

# 注意这行代码,官方提供的demo没有transport='rest' 会出现超时问题,因此一点要加上

genai.configure(api_key=apikey, transport='rest')

model = genai.GenerativeModel('gemini-pro')

response = model.generate_content(text, stream=True)

for chunk in response:

print(chunk.text, end='', flush=True)

if __name__ == '__main__':

apikey = "这里换成ApiKey"

text = "请做一个自我介绍"

test_with_api(apikey=apikey, text=text)

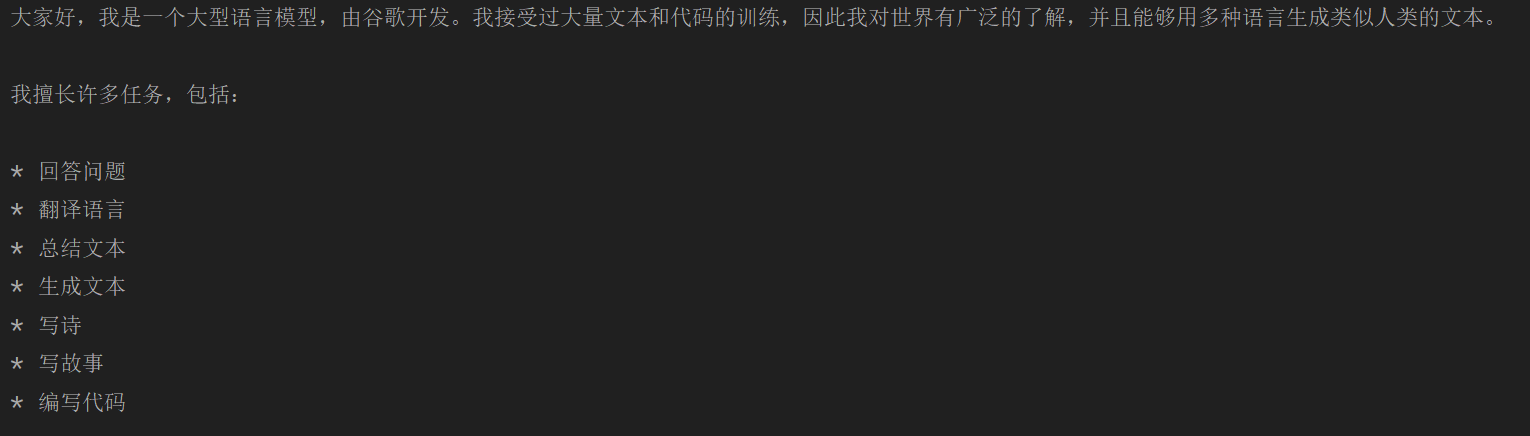

- 输出结果

可能遇到的报错

- 由于每个人电脑的Python环境不同,有可能出现google-auth版本过低等相关报错

解决方案:

升级 google-auth ,在终端执行下面指令

pip install --upgrade google-auth

- 连接超时问题

google.api_core.exceptions.RetryError: Deadline of 60.0s exceeded while calling target function

原因:

1. 网络问题,这个情况自行Google、BaiDu解决

2. 没有设置网络传输方式 transport = ‘rest’,也就是步骤4中提示的注意点,此时需要在代码中修改为 : genai.configure(api_key=apikey, transport='rest')

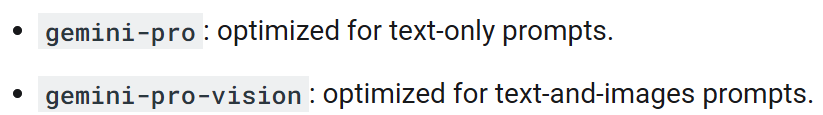

Gemini-Pro模型中其他应用场景

使用gemini-pro-vision进行图片API调用

目前,Gemini提供了2个免费的APi服务:

步骤

- 安装pillow库 : pip install pillow

- 注意:使用的图片格式尽量为jpg格式,并且图片尽量小一点,可以拿500kb以下的进行测试

- 代码

import google.generativeai as genai

import PIL.Image

def test_gemini_pro_vision(apikey, text, image_path):

genai.configure(api_key=apikey, transport='rest')

model = genai.GenerativeModel('gemini-pro-vision')

img = PIL.Image.open(image_path)

response = model.generate_content([text, img], stream=True)

response.resolve()

print(response.text)

if __name__ == '__main__':

apikey = "这里换成ApiKey"

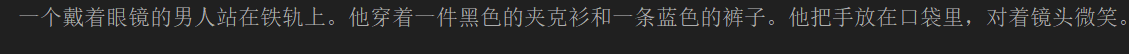

test_gemini_pro_vision(apikey, text="请你描述一下图片的内容。", image_path='2.jpg')

这样改写一下:

- 完全免费,无需API密钥

- 完全本地运行,无需GPU,适用于所有计算机

- 完全私密,一切都在本地进行,采用自定义LLM(语言模型)

- 无需LLM硬件,无需GPU

- 使用免费的ChatGPT3.5 / Qwen / Kimi / ZhipuAI(GLM)API

- 支持自定义LLM(例如ollama、llama.cpp)

- 简便快捷,可通过Docker轻松部署

- 设计了Web和移动友好的界面,专为增强Web搜索的AI聊天而设计,可轻松从任何设备访问

Was this helpful?

0 / 0