全网最全Ollama命令合集

基本使用

拉取模型

ollama pull

ollama pull <MODEL_NAME> 这个命令只是从ollama官网的库中拉取大模型。

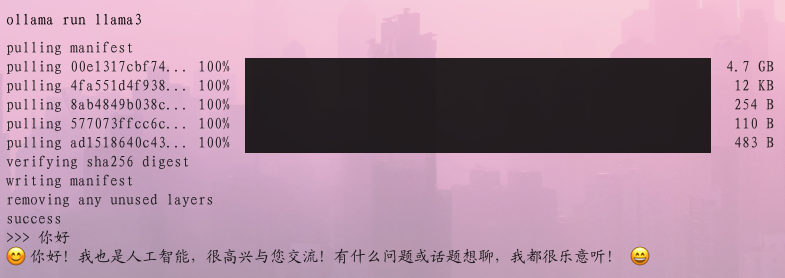

运行模型

ollama run

ollama run <MODEL_NAME> 顾名思义是来运行大模型的,但是如果模型不存在会自动拉取相当于ollama pull <MODEL_NAME> + ollama run <MODEL_NAME>

模型列表

ollama list

展示你拥有的所有模型

展示模型

ollama show

显示模型的信息

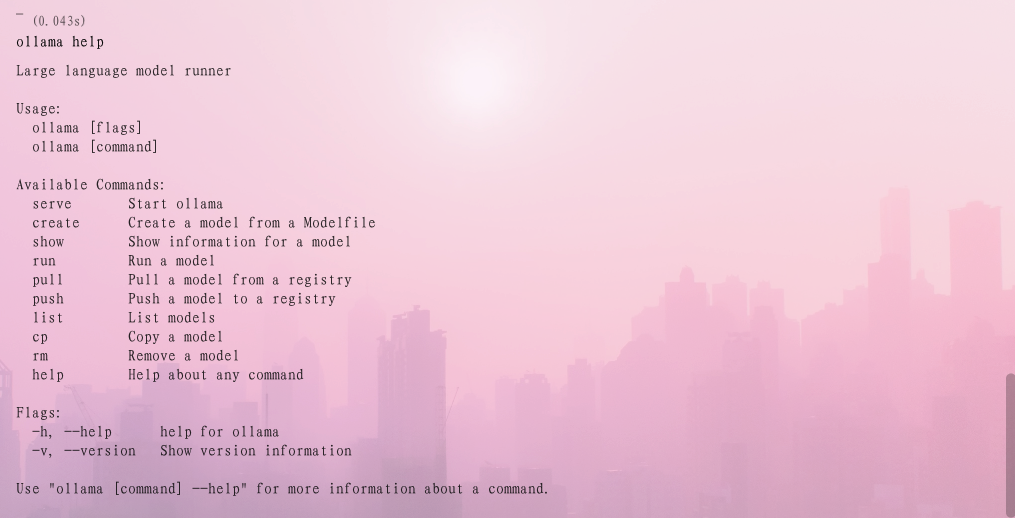

帮助命令

ollama help

常用模型汇总

| Model | Parameters | Size | Download |

|---|---|---|---|

| Llama 3 | 8B | 4.7GB | ollama run llama3 |

| Llama 3 | 70B | 40GB | ollama run llama3:70b |

| Phi-3 | 3,8B | 2.3GB | ollama run phi3 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

| Solar | 10.7B | 6.1GB | ollama run solar |

注意:运行7B模型至少应该有8GB可用内存,运行13B模型至少应该有16GB可用内存,运行33B模型至少应该有32GB可用内存。

Was this helpful?

0 / 1